숟가락 그만 얹어

ANICA 본문

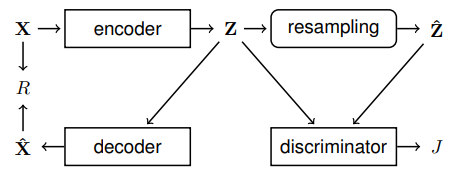

Latent Z에 대한 mutual information (MI)를 minimize하여 source를 얻는 방법이다. MI는 exact computation이 어렵기 때문에 adversarial training을 이용하여 joint probability Pz1z2를 marginal probability Pz1Pz2 분포에 맞추는 방법을 이용한다. Marginal probability는 batch 단위의 데이터에서 batch-wise shuffling하여 feature 간의 independence를 유도한다. (야매) Decoder는 Z의 특성을 X에 constrain하는 역할을 한다.

ICML에서 reject된 이유는 여러 가지 있겠지만, 일반적인 adversarial training은 generator와 discriminator의 싸움이라면 ANICA는 encoder와 encoder가 싸우고 있는 모양이다. 애매한 듯.

References

[1] P. Brakel et al., Learning Independent Features with Adversarial Nets for Non-linear ICA, arXiv 2017

'Research > Representations' 카테고리의 다른 글

| PCA (Principal Component Analysis) (0) | 2022.02.28 |

|---|---|

| Deep Infomax (0) | 2020.12.19 |

| Information Bottleneck (0) | 2020.12.19 |

| MINE (0) | 2020.12.19 |

| VAE + Regression (0) | 2020.08.01 |