숟가락 그만 얹어

Integrated Gradients 본문

x(i)는 input image의 한 pixel이다. x'은 baseline으로 random 값일 수도 있고 0일 수도 있다. x'이 0이라면 검정 배경의 이미지를 서서히 밝게 하면서 누적되는 gradients를 평균하여 input image에 곱한다.

단순 gradient를 importance로 사용하지 않는 이유는 sensitivity 특성을 만족하기 위함이다. x(i) 값이 바뀌었을 때 y의 값도 바뀐다면 x(i)에 대한 contribution이 있어야 하는데 그러지 못한 경우가 있기 때문이다. (ex. 1 - RELU(1 - x) when x > 1)

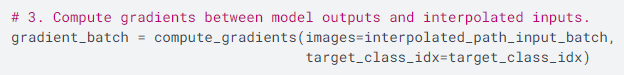

위 식에서 derivative term의 분모는 사실 d(x' + alpha(x - x'))가 되어야 path method의 정의에 더 부합한다고 생각된다. 실제 Tensorflow official 코드에서도 interpolated image에 대해 gradients를 계산하고 있다.

Gradients 방향에 대해

dy/dx가 양의 방향이면 feature x가 y와 관련된 어떤 task의 성능을 높이는 방향으로 기여한다는 의미이다. 반대로 음의 방향이면 task의 성능을 낮추는 기여를 한다. 성능과 상관없이 feature의 순수 contribution만을 고려하려면 gradients에 절댓값을 취하는 것이 바람직하다.

References

[1] M. Sundararajan et al., Axiomatic Attribution for Deep Networks, ICML 2017

'Research > Explainable AI' 카테고리의 다른 글

| 설명 가능한 AI는 설명 가능한가? (0) | 2022.03.06 |

|---|---|

| XAI for VAE (0) | 2021.11.05 |

| SHAP (0) | 2020.10.22 |

| XAI Methods on Time Series (0) | 2020.09.02 |